Vsebina

- Veliki podatki so nestrukturirani ali polstrukturirani

- Ni smiselno shranjevati velikih podatkov, če jih ne moremo obdelati

- Kako Hadoop rešuje problem velikih podatkov

- Poslovni primer za Hadoop

Odvzem:

Hadoop lahko pomaga rešiti nekatere velike izzive podatkov.

Veliki podatki so ... no ... velike velikosti! Točno koliko podatkov lahko razvrščamo med velike podatke, ni zelo jasno, zato se v tej razpravi ne bomo zataknili. Za majhno podjetje, ki se navadi na obdelavo podatkov v gigabajtih, bi bilo 10 TB podatkov VELIKO. Vendar za podjetja, kot sta Yahoo in petabajti, je veliko.Zaradi velikosti velikih podatkov je onemogočeno (ali vsaj stroškovno prepovedano) hranjenja v tradicionalnih shrambah, kot so baze podatkov ali običajne datoteke. Govorimo o stroških za shranjevanje gigabajtov podatkov. Uporaba tradicionalnih datotek za shranjevanje lahko stane veliko denarja za shranjevanje velikih podatkov.

Tu si dobro oglejte velike podatke, njegove izzive in kako jih lahko Hadoop reši.Prvič, veliki podatki so največji izzivi.

Veliki podatki so nestrukturirani ali polstrukturirani

Veliko velikih podatkov je nestrukturiranih. Podatki dnevnika toka na primer lahko izgledajo tako:časovni žig, uporabniški_id, stran, referenčna_stranica

Zaradi pomanjkanja strukture relacijske baze podatkov niso dovolj primerne za shranjevanje velikih podatkov. Poleg tega se veliko baz podatkov ne more spoprijeti s shranjevanjem milijard vrstic podatkov.

Ni smiselno shranjevati velikih podatkov, če jih ne moremo obdelati

Shranjevanje velikih podatkov je del igre. Moramo ga obdelati, da iz njega izkopljemo inteligenco. Tradicionalni sistemi za shranjevanje so precej "neumni" v smislu, da samo shranjujejo koščke. Ne ponujajo nobene procesne moči.Tradicionalni model obdelave podatkov ima podatke, shranjene v shranjevalni skupini, ki so kopirani v računalniško gručo za obdelavo. Rezultati se zapišejo nazaj v skupino za shranjevanje.

Ta model pa ne deluje pri velikih podatkih, ker je kopiranje toliko podatkov v računalniško grozd lahko preveč zamudno ali nemogoče. Kakšen je torej odgovor?

Ena izmed rešitev je obdelava velikih podatkov na mestu, na primer v shranjevalni grozdi, ki se podvoji kot računalniška grozda.

Kot smo videli zgoraj, veliki podatki kljubujejo tradicionalnemu shranjevanju. Kako torej ravnamo z velikimi podatki?

Kako Hadoop rešuje problem velikih podatkov

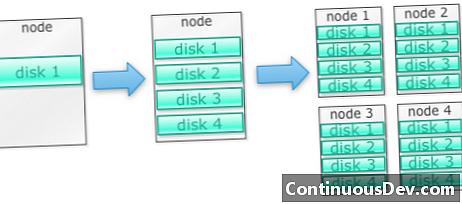

Hadoop je zasnovan tako, da deluje na gruči strojevZačnimo s primerom. Recimo, da moramo shraniti veliko fotografij. Začeli bomo z enim diskom. Ko presežemo en sam disk, lahko uporabimo nekaj diskov, zloženih na stroju. Ko maksimiramo vse diske na enem samem stroju, moramo dobiti kup strojev, vsak s kupom diskov.

Tako je zgrajen Hadoop. Hadoop je zasnovan tako, da deluje na gruči strojev od začetka vožnje.

Hadoop gruče se vodoravno spreminjajo

Več prostora za shranjevanje in računanje je mogoče doseči z dodajanjem več vozlišč v skupino Hadoop. To odpravlja potrebo po nakupu vedno bolj zmogljive in drage strojne opreme.

Hadoop lahko obdela nestrukturirane / polstrukturirane podatke

Hadoop ne uveljavlja sheme podatkov, ki jih hrani. Ta lahko obravnava poljubne in binarne podatke. Tako lahko Hadoop poljubno prebavi vse nestrukturirane podatke.

Hadoop grozdi omogočajo shranjevanje in računalništvo

Videli smo, kako ločevanje skupin za shranjevanje in obdelavo ni najbolj primerno za velike podatke. Hadoop grozdi pa omogočajo shranjevanje in porazdeljeno računanje vse v enem.

Poslovni primer za Hadoop

Hadoop omogoča shranjevanje velikih podatkov po razumnih cenah

Shranjevanje velikih podatkov z običajnim shranjevanjem je lahko drago. Hadoop je zgrajen okoli blagovne strojne opreme, tako da lahko zagotovi dokaj veliko skladiščenje za razumne stroške. Hadoop je bil uporabljen na terenu v petabajtni lestvici.

Ena izmed raziskav Cloudere je pokazala, da podjetja običajno porabijo od 25.000 do 50.000 dolarjev na terabajt na leto. Pri Hadoopu ta strošek pade na nekaj tisoč dolarjev na terabajt na leto. Ko strojna oprema postaja cenejša in cenejša, ta strošek še naprej upada.

Hadoop omogoča zajem novih ali več podatkov

Včasih organizacije ne zajemajo vrste podatkov, ker je bilo preveč shranjevanje stroškov. Ker Hadoop zagotavlja shranjevanje po razumnih stroških, se lahko ta vrsta podatkov zajame in shrani.

En primer so dnevniki klikov na spletnem mestu. Ker je obseg teh dnevnikov lahko zelo velik, jih ni zajelo veliko organizacij. Zdaj je s Hadoopom mogoče zajeti in shraniti hlode.

S Hadoopom lahko podatke shranjujete dlje

Za upravljanje obsega shranjenih podatkov podjetja občasno čistijo starejše podatke. Na primer, lahko so shranjeni samo dnevniki za zadnje tri mesece, starejši dnevniki pa so bili izbrisani. S Hadoopom je mogoče zgodovinske podatke shraniti dlje. To omogoča nove analitike na starejših zgodovinskih podatkih.

Na primer, vzemite dnevnike klikov s spletnega mesta. Pred nekaj leti so bili ti dnevniki za kratek čas shranjeni za izračun statistike, kot so priljubljene strani. Zdaj je s Hadoopom omogočeno hranjenje teh dnevnikov klikov za daljše časovno obdobje.

Hadoop zagotavlja razširljivo analitiko

Vseh teh podatkov ni smiselno hraniti, če jih ne moremo analizirati. Hadoop ne zagotavlja samo distribuirane shrambe, ampak tudi distribuirano obdelavo, kar pomeni, da lahko hkratno drobimo veliko količino podatkov. Računalniški okvir Hadoopa se imenuje MapReduce. MapReduce je dokazano na lestvici petabajtov.

Hadoop zagotavlja bogato analitiko

Native MapReduce podpira Java kot primarni programski jezik. Uporabljajo se lahko tudi drugi jeziki, kot so Ruby, Python in R.

Seveda pisanje kode MapReduce po meri ni edini način za analizo podatkov v Hadoopu. Na voljo je znižanje zemljevida na višji ravni. Na primer, orodje z imenom Pig prevzame angleški jezik kot jezik pretoka podatkov in jih prevede v MapReduce. Drugo orodje, Hive, prevzema poizvedbe SQL in jih izvaja s pomočjo MapReduce.

Orodja poslovne inteligence (BI) lahko zagotovijo še višjo raven analize. Za tovrstne analize obstajajo tudi orodja.

Ta vsebina je izvzeta iz "Hadoop Illuminated" Marka Kerznerja in Sujee Maniyam. Na voljo je prek neporabljene licence Creative Commons Attribution-NonCom Commercial-ShareAlike 3.0.